Schneller als das biologische Vorbild

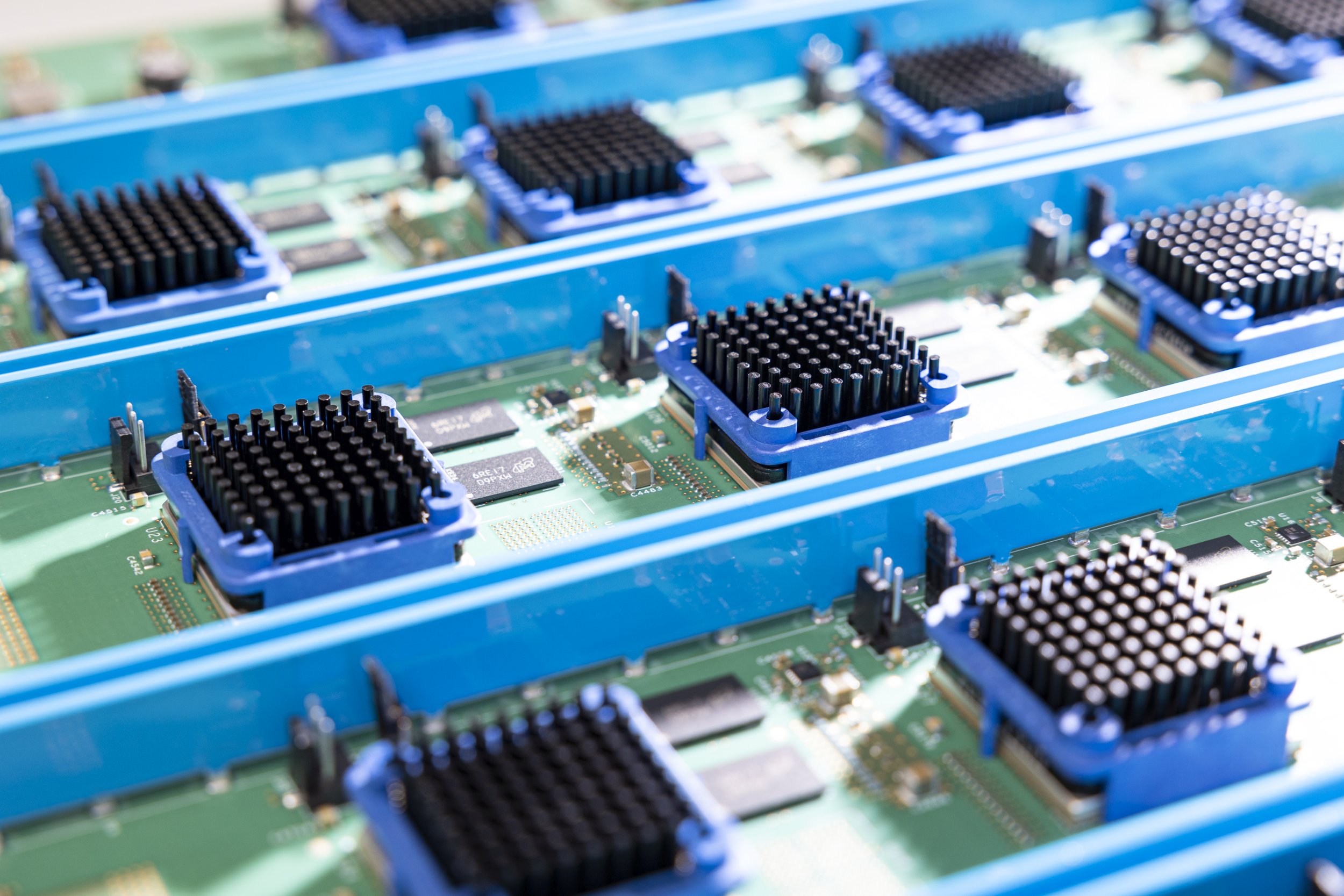

Blick in den FPGA-basierten IBM-Supercomputer INC-3000 am Forschungszentrum Jülich (Copyright: Forschungszentrum Jülich / Sascha Kreklau)

Forscher:innen am Forschungszentrum Jülich haben ein neuronales Netzwerk mit 300 Millionen Synapsen in bislang unerreichter Geschwindigkeit simuliert. Ihnen gelang es, die Netzwerk-Aktivität viermal schneller als in Echtzeit zu berechnen. Für ihren Rekord nutzten sie einen Prototyp des „neuronalen“ IBM-Supercomputers INC-3000. Übergeordnetes Ziel ist es, das Lernen und die Hirnentwicklung besser zu verstehen. Im Interview erläutert Dr. Arne Heittmann, was es damit auf sich hat.

Maschinenlernen und künstliche Intelligenz (KI) haben zuletzt enorme Fortschritte erzielt. Der damit verbundene Rechenaufwand ist allerdings enorm. Das Training der neuronalen Netze findet in der Regel auf Superrechnern statt. Etwa alle drei Monate verdoppelt sich der zeitliche Trainingsaufwand für maschinell lernende Systeme. Setzt sich der Trend fort, werden sich in absehbarer Zukunft bestimmte Lernaufgaben nicht mehr auf die bekannte Art und Weise mithilfe gängiger Algorithmen und Hardware ökonomisch bewältigen lassen.

Eine vielversprechende Lösung bieten hier neuartige Computerarchitekturen, die in ihrem Aufbau dem Gehirn ähneln. Denn das biologische Vorbild ist technischen Systemen in puncto Leistungsfähigkeit und Effizienz meilenweit voraus. Solche neuromorphen Computer könnten darüber hinaus dazu beitragen, biologische Lerndynamiken besser zu verstehen. Diese haben nur wenig mit den bislang genutzten Algorithmen für das maschinelle Lernen gemein. Nach welchen grundlegenden Prinzipien sie im Detail funktionieren, ist noch weitgehend unbekannt.

Jülicher Forscher:innen verfolgen bereits seit einiger Zeit das Ziel, einen solchen neuromorphen Computer zu entwickeln. Dieser soll möglich machen, was auch unter Berücksichtigung zukünftiger technologischer Verbesserungen auf konventionellen Superrechnern nicht erreicht werden kann: Die Simulation neuronaler Netze signifikant beschleunigen. Auf ihrem Weg haben Ingenieurwissenschaftler:innen am Forschungszentrum Jülich nun einen neuen Geschwindigkeitsrekord aufgestellt. Dr. Arne Heittmann vom JARA-Insitut Green IT (PGI-10) erklärt im Interview, was dahinter steckt.

Dr. Arne Heittmann, was ist das für ein Netzwerk, das Sie simuliert haben?

Es handelt sich um ein Netzwerk, das von seiner Größe her etwa 1 Kubikmillimeter der Hirnrinde entspricht. Es besteht aus 80.000 Neuronen, die über 300 Millionen Synapsen miteinander verbunden sind. Ein solches Netzwerk hat noch keine Lernfunktion. Es soll vielmehr eine realitätsnahe Vernetzung abbilden und erzeugt gerade genügend Stimulus, um zu biorealistischen Aktivitätsmustern zu kommen. Das Netz beschäftigt sich praktisch selbst – man spricht hier auch von einem rekurrenten Netz, das mit den Aktivitätsmustern, die es produziert, wieder eigene Aktivitätsmuster hervorruft. Dieses Netzwerk ist sehr gut untersucht und eignet sich daher, um die Leistungsfähigkeit von Computerarchitekturen hinsichtlich der Simulation von neuronalen Netzen miteinander zu vergleichen. Allerdings umfasst dieses Netzwerk nur etwa ein Millionstel eines menschlichen Gehirns, und ist damit immer noch viel zu klein, um zu verlässlichen Aussagen über das Gehirn an sich zu kommen.

Warum tun sich herkömmliche Rechner bei der Simulation von Lernvorgängen so schwer?

Biologische Gehirne sind vollkommen anders aufgebaut als die Computersysteme, wie sie beispielsweise im High-Performance-Computing (HPC) eingesetzt werden. Während in klassischen Supercomputern nur verhältnismäßig wenige, hochgetaktete Prozessoren unter strikter Trennung von Speicher- und Prozessoreinheiten Berechnungen durchführen, ist ein Gehirn aus einer massiven Anzahl hochgradig vernetzten Neuronen aufgebaut. Jedes Neuron für sich arbeitet zwar extrem langsam und damit energiesparend, dennoch ist unser Gehirn extrem leistungsfähig, da die Nervenzellen vollständig parallel arbeiten. Zudem ist der Grad der Vernetzung im Gehirn extrem. 80 Prozent des Hirnvolumens werden allein von Verbindungen zwischen Nervenzellen belegt. Die eigentlichen Neurone machen dagegen nur 16 bis 20 Prozent aus.

Ein weiteres grundlegendes Problem aller konventionellen Computerarchitekturen ist die strikte Trennung von Prozessor und Speicher. Biologische Nervenzellen dagegen können Informationen sowohl verarbeiten als auch speichern. In herkömmlichen Computersystemen müssen alle Informationen über eine enge Schnittstelle vom Prozessor zu einem Speichersystem transportiert werden, das ist der sogenannte Von-Neumann-Flaschenhals. Dies führt zu einer gewissen Verzögerung, Latenz genannt. Diese Latenz wird sich auch mit neuen Speichertechnologien nicht signifikant verbessern und bestimmt die Simulationsgeschwindigkeit maßgeblich, wie wir in unseren Untersuchungen nachweisen konnten. Die Kommunikation zwischen Nervenzellen ist zudem extrem energiesparend und geschieht fast ausschließlich über extrem spärliche neuronale Aktivitätsmuster. Übersetzt auf unsere Supercomputer bedeutet dies, dass man es ausschließlich mit sehr kurzen Datenpaketen zu tun hat. Die vorrangigen Computerstandards sind aber gerade für große Datenpakete optimiert. Auch bei der Kommunikation entstehen so für kurze Datenpakete große Latenzen.

Bei der Simulation eines Netzwerks mit 300 Millionen Synapsen in Rekordgeschwindigkeit kam der Prototyp eines Rechners von IBM zum Einsatz, der auf sogenannten FPGAs basiert. Was ist das für ein System? Ist es eine geeignete Lösung für die Zukunft?

Wir nutzen das INC-System von IBM vorrangig, weil sich damit unterschiedliche Schaltungen sehr flexibel herstellen lassen. FPGAs, Field Programmable Gate Arrays, enthalten frei programmierbare Logikbausteine mit eigenem Speicher und weiteren Hardware-Komponenten auf einem Chip. Weil der Speicher so nah an der Logik platziert ist, fallen die zuvor angesprochenen Speicher-Latenzen nicht ins Gewicht. Die Bausteine auf dem FPGA lassen sich außerdem beliebig umprogrammieren. Dies ist hilfreich, um beispielsweise verschiedene Architekturvarianten zu untersuchen. Da wir die optimale Architektur und Schaltung im Vorfeld nicht immer eindeutig identifizieren können, hilft uns die schnelle Rekonfigurierbarkeit, gute Lösungen herauszuarbeiten. So konnten wir auch die optimale Schaltung finden, die den genannten Beschleunigungsfaktor ermöglichte.

Schon für Netze, die derzeit zum Beispiel zur Modellierung des visuellen Kortex untersucht werden und nur aus einigen wenigen Millionen Neuronen bestehen, wird die Simulationsgeschwindigkeit im Vergleich zum hier simulierten Netz auf dem IBM INC-System deutlich geringer sein. Auf einem herkömmlichen Superrechner ist ein solches Netz sogar nur 30-mal langsamer als in Echtzeit simulierbar.

Man muss auch bedenken: Derzeit werden in Simulationen noch sehr einfache Neuron- und Synapsenmodelle verwendet, die nur mit einer Handvoll mathematischer Gleichungen beschrieben werden können. Dieses Neuronenmodell ist aber mehr 120 Jahre alt. Es ist absehbar, dass eine realistischere Abbildung der Neuronendynamik und Lernvorgänge noch viel mehr Gleichungen benötigt, beispielsweise zur Beschreibung von Dendriten. Dabei handelt es sich um fein verzweigte Verästelungen, über die sich Nervenzellen untereinander verbinden. Heute weiß man: Diese Dendriten stellen keine passiven Leitungen dar und tragen aktiv zur Informationsverarbeitung bei. Schätzungsweise mehr als zwei Drittel der neuronalen Dynamik hängt davon ab. Diese dendritischen Strukturen finden heute noch gar keine Berücksichtigung. Zukünftig wird man also auch deutlich mehr Recheneinheiten benötigen, als heute in einem Prozessor zur Verfügung stehen, um die Vielzahl der gekoppelten Gleichungen in passabler Zeit zu lösen.

Andere neuromorphe Computersysteme wie die SpiNNaker-Architektur der Universität Manchester oder das BrainScaleS-System der Universität Heidelberg werden ebenfalls für neuronale Simulationen genutzt. Wo liegen die verschiedenen Vor- und Nachteile der Systeme?

Grundsätzlich sind die Systeme umso schneller, je direkter sie ein neuronales Netzwerk auf Hardware-Ebene nachbilden. Das BrainScaleS-System aus Heidelberg besteht aus mehreren Wafern. Die Neuronen sind mitsamt ihren Verbindungen direkt auf dem Chip angelegt. Dieses System ist naturgemäß sehr schnell. Die Größe des Netzwerks, das sich auf diese Weise darstellen lässt, ist jedoch begrenzt. 300 Millionen Synapsen, wie wir sie simuliert haben, wären damit nicht machbar. Das Problem einer solchen Spezialarchitektur ist außerdem, dass man nachher unter Umständen nicht flexibel genug ist, um neue Features einzubauen.

Das britische System SpiNNaker gleicht dagegen eher einem herkömmlichen Superrechner. Es handelt sich hier um einen massiv-parallelen Computer, der über mehrere Hunderttausend ARM-Prozessoren, die eigentlich für Mobilfunkanwendungen optimiert sind, und ein besonderes Kommunikationsnetzwerk verfügt. Da hier ein zentraler Prozessor und ein davon abgetrennter Speicher vorliegen, läuft man wie bei allen herkömmlichen Rechnern automatisch in die Problematik mit der Latenz, also des verzögerten Transports von Informationen.

Und was ist mit Grafikprozessoren (GPUs), die ja auch intensiv für die künstliche Intelligenz genutzt werden?

GPUs werden derzeit vor allem für klassische neuronale Netze eingesetzt, eine realitätsgetreue Abbildung biologischer Netzwerke steht hier meist nicht im Vordergrund. Dabei geht es vor allem um Deep-Learning-Algorithmen. In GPU-basierten Systemen ist der Grad der Parallelität extrem hoch, das heißt, sie verfügen über vergleichsweise viele Recheneinheiten. Doch auch hier müssen Daten zwischen Prozessor und Speicher hin und her transportiert werden, was letztlich wieder das Problem mit der Latenz betont. Verglichen mit dem biologischen Gehirn sind GPUs außerdem immer noch extreme Energiefresser. Ein menschliches Gehirn hat eine Leistung von etwa 20 Watt, typische Serverfarmen mit GPU-basierten Rechenknoten kommen dagegen auf mehrere Mega-Watt, benötigen im Betrieb also das Hunderttausendfache an Energie.

Der neuronale Supercomputer von IBM, mit dem Sie gerechnet haben, war nur ein Testsystem. Welches finale System schwebt Ihnen vor?

Im Projekt „Advanced Computing Architectures (ACA): towards multi-scale natural-density Neuromorphic Computing” arbeiten wir daran, Konzepte zu benennen, die wir brauchen, um große Netzwerke, die sehr komplex sind, berechnen zu können. Das wäre dann etwa ein Netzwerk mit 1 Milliarde Neurone, das so groß ist wie das Gehirn eines Säugetieres. In dem Projekt kooperieren wir übrigens mit der RWTH Aachen, der University of Manchester und der Universität Heidelberg, die teils auch eigene neuromorphe Ansätze verfolgen. Übergeordnetes Ziel ist der Bau eines Computersystems, das es ermöglicht, Lernprozesse im Zeitraffer zu untersuchen. Das IBM INC-3000-System kam im Rahmen der Machbarkeitsstudie zum Einsatz und hat gezeigt, dass selbst bei Verwendung modernster Technologien dem erzielbaren Leistungsgewinn grundsätzlich Grenzen gesetzt sind. Neue, unkonventionelle Architekturen, Schaltungs- und Speicherkonzepte sind hier unumgänglich. Hierbei müssen, wie bereits oben angedeutet, Konzepte der Speicherarchitektur, der Kommunikation und der numerischen Berechnungseinheiten völlig neu elaboriert werden.

Langfristiges Ziel ist die Entwicklung einer eigenen Architektur, die speziell auf diese Art von Simulationen zugeschnitten ist. Eine solche neuromorphe Beschleuniger-Architektur könnte dann idealerweise angekoppelt werden an die Jülicher Supercomputing-Infrastruktur. Wir reden hier aber über einen großen Zeithorizont von 15 bis 20 Jahren.

– Interview: Tobias Schlößer –

Originalveröffentlichung: Arne Heittmann, Georgia Psychou, Guido Trensch, Charles E. Cox, Winfried W. Wilcke, Markus Diesmann and Tobias G. Noll

Simulating the Cortical Microcircuit Significantly Faster Than Real Time on the IBM INC-3000 Neural Supercomputer, Front. Neurosci. (published on 20 January 2022), DOI:10.3389/fnins.2021.728460

Ansprechpartner

Dr. Arne Heittmann

Peter Grünberg Institut (PGI)

Gebäude 04.6 /

Raum 48b

+49 2461/61-6117

Tobias Schlößer

Pressereferent

Gebäude 15.3 /

Raum 3028a

+49 2461/61-4771

Originalpublikation:

Schneller als das biologische Vorbild (fz-juelich.de)

Media Contact

Alle Nachrichten aus der Kategorie: Informationstechnologie

Neuerungen und Entwicklungen auf den Gebieten der Informations- und Datenverarbeitung sowie der dafür benötigten Hardware finden Sie hier zusammengefasst.

Unter anderem erhalten Sie Informationen aus den Teilbereichen: IT-Dienstleistungen, IT-Architektur, IT-Management und Telekommunikation.

Neueste Beiträge

Ist der Abrieb von Offshore-Windfarmen schädlich für Miesmuscheln?

Rotorblätter von Offshore-Windparkanlagen unterliegen nach mehrjährigem Betrieb unter rauen Wetterbedingungen einer Degradation und Oberflächenerosion, was zu erheblichen Partikelemissionen in die Umwelt führt. Ein Forschungsteam unter Leitung des Alfred-Wegener-Instituts hat jetzt…

Per Tierwohl-Tracker auf der Spur von Krankheiten und Katastrophen

DBU-Förderung für Münchner Startup Talos… Aus dem Verhalten der Tiere können Menschen vieles lernen – um diese Daten optimal auslesen zu können, hat das Münchner Startup Talos GmbH wenige Zentimeter…

Mit Wearables die Gesundheit immer im Blick

Wearables wie Smartwatches oder Sensorringe sind bereits fester Bestandteil unseres Alltags und beliebte Geschenke zu Weihnachten. Sie tracken unseren Puls, unsere Schrittzahl oder auch unseren Schlafrhythmus. Auf welche Weise können…